Klimaforschung

Die Pionierdisziplin punkto Digitalisierung

Die Digitalisierung hat schon vor mehr als 50 Jahren die Klimawissenschaft umgewälzt – und das Wissen über den menschgemachten Klimawandel erst möglich gemacht. Die Klimaforschung hat damit Computermodellen auch in anderen Bereichen zum Durchbruch verholfen. Heute sind sie in der Wissenschaft nicht mehr wegzudenken.

Am Anfang stand das Wetter – und die Bombe. Als Ende der 1940er-Jahre erste Vorläufer der heutigen Computer in Forschungslabors auftauchten – sogenannte Von-Neumann-Rechner – ging es einerseits um bessere Wettervorhersagen, andrerseits lieferten Berechnung der Neutronenstreuung Grundlagen für den Bau von Atombomben. In den 1960er-Jahren programmierte der Physiker Syukuro Manabe das erste unter Forschenden als realistisch geltende Klimamodell, womit er seine 1967 veröffentlichte Vorhersage zum menschengemachten Klimawandel erstellte: Bei einer Verdopplung der CO2-Konzentration in der Atmosphäre, so Manabe, steige die Temperatur um rund 2,5 Grad Celsius. Für seine Arbeiten wurde der Japaner 2021 mit dem Nobelpreis für Physik ausgezeichnet.

Auch die Universität Bern spielte beim Epochenwechsel, der die Einführung von Computermodellen in der Klimaforschung ab den 1960er-Jahren darstellte, eine wichtige Rolle. Der Berner Nuklearphysiker Hans Oeschger hatte eine Methode entwickelt, mit deren Hilfe sich der CO2-Gehalt in der Atmosphäre vergangener Jahrtausende aus Eisbohrkernen rekonstruieren liess. «Für die noch jungen Klimamodelle war das Wissen über vergangene Klimaveränderungen enorm wertvoll, konnten sie doch erst mit den Daten der Vergangenheit kalibriert werden», schreibt die Wissenschaftshistorikerin Dania Achermann (UniPress 179, Februar 2020).

Simulationen – eine Erfolgsgeschichte

Heute sind Computermodelle aus den Klimawissenschaften nicht mehr wegzudenken: Ganz gleich ob bei den Berechnungen des Weltklimarats IPCC zur globalen Klimazukunft, einer Untersuchung zur Übersterblichkeit während des Hitzesommers 2022 in der Schweiz oder für eine Studie zur künftigen Waldbrandgefahr im Kanton Bern, überall braucht es Computermodelle oder präziser gesagt Simulationen. Die Methode hat sich nicht nur in der Klimaforschung, sondern in den meisten Bereichen der Wissenschaften durchgesetzt. «Die Idee, etwas mit dem Computer zu simulieren, ist eine Erfolgsgeschichte, deren Anfänge unter anderem in der Modellierung der Atmosphäre liegen», erklärt Claus Beisbart, Professor für Wissenschaftsphilosophie an der Universität Bern und Mitglied des Oeschger-Zentrums für Klimaforschung. «Simulationen haben neue Türen aufgemacht, bestimmte Dinge konnte man vorher gar nicht berechnen.»

Grundlage jeder Computersimulationen ist ein Set mathematischer Gleichungen – im Fall der Klimamodelle sind es die sogenannten Navier-Stokes-Gleichungen zur Beschreibung der Atmosphärendynamik. Entwickelt wurde dieses mathematische System bereits Mitte des 19. Jahrhunderts, doch das Lösen seiner Differenzialgleichungen ist derart komplex, dass es sich erst mithilfe von Computern effizient bewerkstelligen liess.

Eine Hypothese nach der anderen durchtesten

Längst lassen sich mit Computersimulationen nicht mehr bloss physikalische Phänomene beschreiben, sondern zum Beispiel auch biologische. Christoph Schwörer etwa arbeitet mit einem dynamischen Vegetationsmodell. Er ist Postdoktorand in der Paläoökologie-Gruppe des Oeschger-Zentrums. Das Modell, das er einsetzt, nennt sich LandClim und wurde an der ETH Zürich entwickelt, um die Bedeutung von Klimaeffekten, Waldbränden und der Waldbewirtschaftung auf die Dynamik von Wäldern zu simulieren. Schwörer erforscht, wie sich Klimaveränderungen und menschliche Aktivitäten in der Vergangenheit auf die Vegetation ausgewirkt haben.

Dazu analysiert er Pollen, Makrofossilien und Holzkohlepartikel, die sich in den Sedimenten von Seen finden. So lassen sich vergangene Veränderungen zwar rekonstruieren, doch weshalb es dazu kam, bleibt oft im Dunkeln. «Mit unserem Computermodell», erklärt Schwörer, «können wir verschiedene Hypothesen testen.» Dazu wird jeweils nur eine der möglichen Einflussgrössen wie etwa Feuer, Klima oder Rodungen verändert, die anderen bleiben konstant. «Wenn sich beim Durchspielen dieser Möglichkeiten Landschaftsveränderungen zeigen, die mit unseren Daten übereinstimmen», so Schwörer, «dann spricht das für die getestete Hypothese.»

Daten alleine reichen nicht

Auch der Geowissenschafter Frerk Pöppelmeier ist auf Computersimulationen angewiesen. «In meinem Forschungsbereich kommt man mit Daten allein nicht mehr weiter», betont er. «Um der Wahrheit etwas näher zu kommen, muss man Messresultate mit Modellen verknüpfen.» Als Postdoktorand in der Gruppe «Erdsystemmodellierung: Klimadynamik» des Oeschger-Zentrums hat Pöppelmeier das Umfeld gefunden, das er suchte, um seine Forschung voranzutreiben. Sein Thema: vergangene Veränderungen in der atlantischen Zirkulation, die er mittels geochemischer Proxies (indirekte Anzeiger des Klimas aus natürlichen Archiven) aus marinen Sedimentkernen rekonstruiert. Anhand dieser Daten führt er anschliessend mit dem an der Universität Bern entwickelten «Bern3D»-Modell Simulationen durch. «Mithilfe des Models untersuchen wir, wie sich Störfaktoren auf die atlantische Zirkulation auswirken, und versuchen das in Einklang mit den Rekonstruktionen zu bringen.»

Modelle selbst bauen

Benjamin Stocker setzt Computermodelle nicht nur ein, er baut sie gleich selbst, und er entwickelt bestehende Modelle weiter. Sein Ziel ist es, Modelle zu verbessern, damit sie die Folgen des Klimawandels auf Landökosysteme realistisch wiedergeben. Dazu müssten sie in der Lage sein, zum Beispiel den Effekt von Nährstoffen auf den globalen Kohlenstoffkreislauf zu simulieren, erklärt der Leiter der Forschungsgruppe «Geodaten und Erdbeobachtung» des Oeschger-Zentrums. Den heutigen Modellen gelinge dies nur sehr unzureichend. Benjamin Stocker und sein Team beschäftigen sich damit, wie sich die Auswirkungen des Klimawandels – zum Beispiel auf das Wachstum von Pflanzen – in mathematische Gleichungen fassen lassen. So zeigen Beobachtungen und Experimente, dass sich Pflanzen dynamisch anpassen, um von der steigenden CO2-Konzentration profitieren zu können: Das Verhältnis zwischen neu gebildeten Blättern und Wurzeln etwa verschiebt sich. Damit die Pflanzen mehr Nährstoffe aufnehmen können, produzieren sie mehr Wurzeln.

«Dieses Muster ist sehr wichtig, um künftige Entwicklungen im globalen Kohlenstoff- und Nährstoffkreislauf zu simulieren», erklärt Benjamin Stocker. «Wir wollen zeigen, wie gekoppelte Erdsystemmodelle in dieser Richtung verbessert werden können.» Übrigens: Die modulartigen Weiterentwicklungen der Gruppe «Geodaten und Erdbeobachtung» sind Open Access, sie werden also der gesamten Forschungscommunity, wie die meisten Klimamodelle, offen zur Verfügung gestellt.

«Simulationen müssen in der Lage sein, vergangenes Klima zu reproduzieren.»

Claus Beisbart

Wie die drei Beispiele aus dem Oeschger-Zentrum zeigen, ist die Digitalisierung in der Klimaforschung weit fortgeschritten. Computersimulationen sind seit Langem etablierte Werkzeuge; neuerdings setzen manche Forschenden auch künstliche Intelligenz ein, insbesondere Machine Learning. Doch auch wenn Computermodelle aus der Forschung nicht mehr wegzudenken sind, bleibt eine grundsätzliche Frage: Wie vertrauenswürdig sind die so erzielten Forschungsresultate?

Fragen wir den Wissenschaftsphilosophen, der in seiner ersten Karriere Physiker war. Claus Beisbart, weshalb können wir Computermodellen glauben? «Die Glaubwürdigkeit von Computersimulationen beruht auf zwei Dingen. Erstens auf Naturgesetzen oder Theorien und zweitens darauf, dass die Simulationen mithilfe von Daten getestet werden.» Je etablierter die Theorien seien, die einer Simulation zugrunde liegen, so Beisbart, desto glaubwürdiger sei diese. Und: Simulationen müssen in der Lage sein, vergangenes Klima zu reproduzieren. Sie werden durch die Passung zwischen dem Simulationsoutput und Daten der Vergangenheit validiert. «Die Glaubwürdigkeit von Simulationen basiert darauf, dass Mechanismen widergegeben werden, die wir verstehen», fasst Claus Beisbart zusammen.

Digitalisierung birgt auch Gefahren

Hat sich die jahrzehntelange Arbeit mit Computersimulationen auch auf die wissenschaftliche Praxis ausgewirkt? Durchaus, meint der Wissenschaftsphilosoph. «Es haben sich neue Formen der Kooperation herausgebildet.» Simulationen seien oft derart umfangreich, dass sie nicht mehr von kleinen Gruppen gemacht werden könnten, das habe die Zusammenarbeit gefördert. Teile von Programmcodes würden heute hin und her geschoben. Allein zu arbeiten, wie früher etwa in der theoretischen Physik, sei bei vielen Computersimulationen undenkbar.

Apropos Programmcodes: Claus Beisbart sieht durch die Spezialisierung auf Computermodelle traditionelle wissenschaftliche Karrierewege in Gefahr. Viele Nachwuchsforschende seien heute vor allem als Programmierer gefragt, doch in dieser Funktion sei es schwierig, mit Publikationen ein eigenes Profil zu entwickeln. Wissenschaftliche Karrieren liessen sich so keine aufbauen, gibt er zu bedenken.

Wissenschaftliche Kreativität bleibt zentral

In der Wissenschaftsphilosophie macht man sich aber noch viel grundsätzlichere Gedanken zu Computersimulationen. Was lässt sich damit wirklich lernen? Bei Experimenten sei der Ausgang offen, und das mache sie interessant, so Beisbart: «Da antwortet die Natur.» Bei Computersimulationen hingegen sei das Ergebnis bereits in den Modellannahmen enthalten, sie könnten nur so gut sein wie diese Annahmen. Daraus folgert der Physiker und Philosoph zwei Dinge. Erstens: Computersimulationen können das Experiment nicht vollständig ersetzen. Und zweitens: Manchmal muss man die Grundannahmen einer Simulation verändern. Wie das zu bewerkstelligen ist, lässt sich nicht aus der Simulation ableiten. «Die Entwicklung einer neuen Theorie braucht eine Form von Kreativität, die über die Simulation hinausführt.»

Zur Person

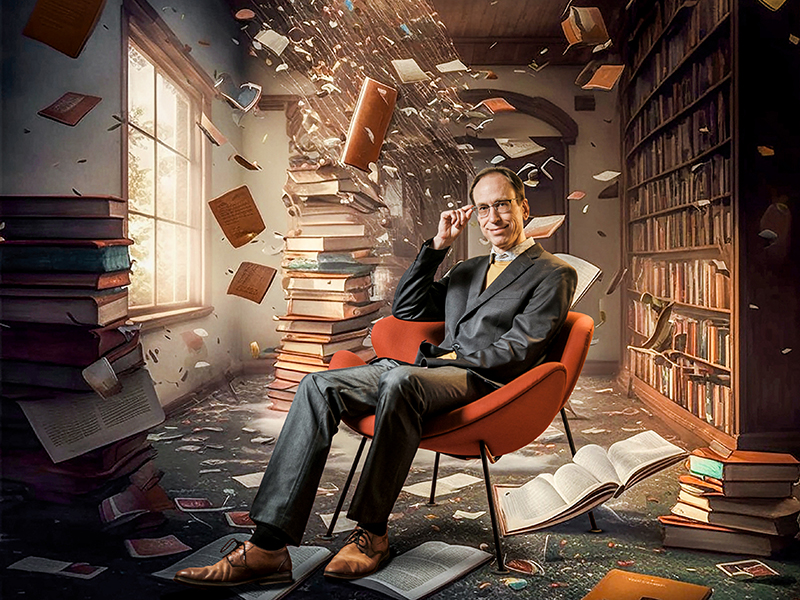

Prof. Dr. Claus Beisbart

ist Professor am Institut für Philosophie und Extraordinarius mit Schwerpunkt Wissenschaftsphilosophie an der Universität Bern. Seine Forschungsinteressen umfassen Wissenschaftsphilosophie, Philosophie der Physik und praktische Philosophie.

Kontakt:

Prof. Dr. Claus Beisbart, Institut für Philosophie, Universität Bern, claus.beisbart@unibe.ch

Das Online-Magazin der Universität Bern

uniAKTUELL als Newsletter abonnieren

Die Universität Bern betreibt Spitzenforschung zu Themen, die uns als Gesellschaft beschäftigen und unsere Zukunft prägen. Im uniAKTUELL zeigen wir ausgewählte Beispiele und stellen Ihnen die Menschen dahinter vor – packend, multimedial und kostenlos.

Das Print-Magazin der Universität Bern

4x im Jahr uniFOKUS im Briefkasten

Dieser Artikel erschien erstmals in uniFOKUS, dem neuen Printmagazin der Universität Bern. uniFOKUS zeigt viermal pro Jahr, was Wissenschaft zu leisten vermag. Jede Ausgabe fokussiert aus unterschiedlichen Blickwinkeln auf einen thematischen Schwerpunkt und will so möglichst viel an Expertise und Forschungsergebnissen von Wissenschaftlerinnen und Wissenschaftlern der Universität Bern zusammenführen.